📚 Continue Lendo

Mais artigos do nosso blog

A **História da Inteligência Artificial** remonta a questionamentos formulados há mais de setenta anos, sobre se máquinas seriam capazes de raciocinar de forma semelhante à mente humana. Hoje, essa discussão ganha novos contornos, com o avanço tecnológico que nos faz indagar constantemente a origem do conteúdo que consumimos ou com quem interagimos. Seja ao dialogar com um chatbot em plataformas de e-commerce, ao tentar determinar a autoria de trabalhos acadêmicos ou durante um processo seletivo para uma vaga de emprego, a distinção entre o que é produzido por um ser humano ou por um algoritmo se tornou um desafio cada vez mais complexo.

Essa realidade massiva foi prevista há décadas. O cenário atual, onde a inteligência artificial permeia aspectos cotidianos, desde a experiência de compra até processos de recrutamento, reflete uma complexidade tecnológica que borra as linhas do discernimento humano. Tais fenômenos foram, em grande parte, antecipados por Alan Turing.

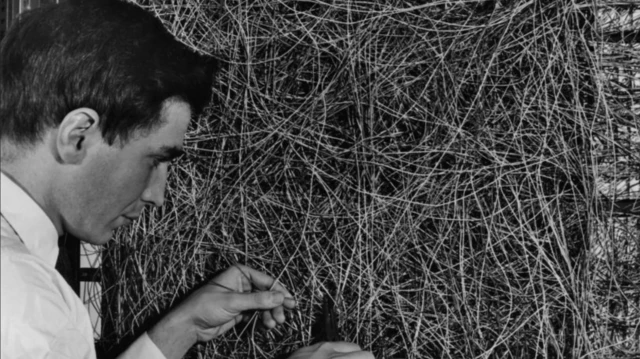

Há setenta anos, precisamente em 1950, o cientista britânico Alan Turing publicou o seminal artigo “Computing Machinery and Intelligence”. O texto se inicia com uma indagação provocativa: podem as máquinas, de fato, pensar? Esta questão lançou as bases para um campo de pesquisa que evoluiria através de décadas de inovações, disputas teóricas e importantes marcos.

A História da Inteligência Artificial: Das Origens aos Desafios Atuais

O percurso da inteligência artificial, que transformou a visão inicial de Turing nas robustas tecnologias contemporâneas, foi marcado por diversas abordagens científicas. Para compreender a amplitude dessa jornada, pesquisadores têm explorado uma vasta literatura científica e acadêmica, que analisa os fundamentos e as controvérsias do setor, oferecendo um panorama sobre as distintas perspectivas que moldaram a inteligência artificial ao longo do tempo. No entanto, o termo “inteligência artificial” só seria formalmente introduzido mais tarde.

O papel de Alan Turing (1912-1954) como precursor da inteligência artificial é inquestionável, embora a expressão ainda não existisse em sua época. Somente em 1956, o cientista da computação John McCarthy (1927-2011) cunharia o termo “artificial intelligence”. As propostas de Turing, no entanto, influenciariam profundamente o campo por muitas décadas. Seu artigo apresentou um experimento, posteriormente conhecido como Teste de Turing, uma variação do “Jogo da Imitação”. Neste jogo, um interrogador tenta distinguir entre um homem e uma mulher baseando-se apenas em mensagens escritas. Turing propôs substituir um dos participantes humanos por uma máquina; se o interrogador fosse incapaz de identificar qual é a máquina, o sistema teria atingido a capacidade de “pensar”.

Em 1951, Turing já abordava a temática da computação em uma palestra para a BBC, com o roteiro original de sua apresentação e suas anotações manuscritas ainda preservados nos arquivos da emissora. No artigo, ele vaticinava que, dentro de 50 anos (por volta de 2000), os computadores seriam capazes de armazenar informações suficientes para que interrogadores tivessem menos de 70% de chance de identificar a máquina em cinco minutos de perguntas. Ele também anteviu o conceito de aprendizado de máquina, sugerindo que, em vez de programar sistemas por completo, eles deveriam ser criados para aprender a partir de dados, como um “cérebro infantil” que evolui com a “educação apropriada”. Essa antecipação é destacada pelo professor de História da USP, Victor Sobreira, que pontua como as previsões de Turing delinearam o desenvolvimento da IA atual. O Prêmio Turing, considerado o “Nobel da computação”, cimentou ainda mais seu legado como uma figura central.

Apesar da vanguarda de Turing, a ideia de automatizar processos humanos não era nova. Anderson Rocha, professor titular do Instituto de Computação da Unicamp, cita exemplos desde a mitologia grega, com o autômato Talos, até as discussões de Aristóteles na “Política” sobre máquinas ajudarem no trabalho e eliminarem a escravidão. O termo “inteligência artificial” consolidou-se, contudo, no famoso Dartmouth College, nos EUA, na década de 1950.

Dartmouth e a Gênese da Expressão “Inteligência Artificial”

Karen Hao, jornalista e autora do livro “Empire of AI”, detalha que a expressão “inteligência artificial” surgiu em 1956, durante uma conferência no Dartmouth College. O encontro reuniu cerca de vinte cientistas — em suas palavras, “todos homens brancos” — de diversas áreas como matemática, criptografia e ciências cognitivas. Inicialmente, John McCarthy, o organizador, referia-se ao campo como “automata studies”. Contudo, percebendo a falta de apelo do termo, optou por “artificial intelligence”, numa estratégia de marketing para atrair atenção e financiamento. A palavra “inteligência” transmitia sofisticação e benefícios, conferindo uma identidade a essa disciplina emergente.

Ainda que Dartmouth seja vista como um “mito fundador”, Victor Sobreira observa que o encontro, apesar de durar dois meses, não gerou avanços práticos imediatos. No entanto, reuniu nomes que se tornariam referências da área nos Estados Unidos, estabelecendo centros de pesquisa no MIT e Stanford e definindo o direcionamento da IA por décadas, como McCarthy e Marvin Minsky. Essa fase inicial já apresentava uma característica marcante da IA: o “hype” associado. No entanto, a perspectiva de “mito de origem” também enfrenta críticas. Um artigo de 2023 na revista BJHS Themes, por exemplo, ressalta que as bases da IA também se conectam a outras trajetórias históricas, como a industrialização, o militarismo e o colonialismo, evidentes na dependência de minerais de regiões carentes e na reprodução de lógicas classificatórias.

A Batalha de Visões: Simbolistas e Conexionistas

Após a conferência de Dartmouth, surgiram duas correntes dominantes para definir e desenvolver a inteligência. No livro “Empire of AI”, Karen Hao descreve os “simbolistas”, que defendiam a ideia de que a inteligência se baseava no conhecimento, o que levou à criação de “expert systems” e linguagens como Prolog, utilizadas, por exemplo, na aviação, como explica Anderson Rocha. Já os “conexionistas” acreditavam que a inteligência era fruto do aprendizado. Essa vertente focou no desenvolvimento de sistemas de aprendizado de máquina que replicam o processamento de informações do cérebro humano, dando origem às redes neurais, alicerce da IA moderna.

Em julho de 1958, o jornal americano The New York Times publicou um anúncio impactante sobre o Perceptron, um protótipo desenvolvido pelo professor de psicologia Frank Rosenblatt, da Universidade de Cornell. O periódico relatou que a máquina seria o primeiro dispositivo a “pensar como o cérebro humano”, capaz de “cometer erros, mas ficar mais inteligente com a experiência”. O Perceptron, que identificava padrões para diferenciar letras, foi pioneiro na construção de uma máquina baseada em redes neurais, conforme documentado por Victor Sobreira. Contudo, essa abordagem enfrentou dificuldades devido aos altos custos, limitada capacidade computacional e insuficiência de dados. Marvin Minsky, um dos organizadores de Dartmouth e crítico dos conexionistas, teria contribuído para limitar o financiamento dessa linha de pesquisa por anos.

Apesar da proeminência da abordagem simbólica por muitos anos, o advento da internet, das redes sociais e das Unidades de Processamento Gráfico (GPUs) revolucionou o cenário. Essa convergência tecnológica proporcionou o volume massivo de dados e o poder computacional necessários para empoderar a visão original das redes neurais, impulsionando a IA conexionista a um protagonismo econômico e social, como observa Anderson Rocha. Ele complementa que, atualmente, embora a abordagem simbólica esteja em desvantagem devido à dificuldade de traduzir o conhecimento de especialistas em regras lógicas, a conexionista, por sua vez, também possui limitações. Por isso, um movimento atual busca unir as duas correntes em uma “IA neurossimbólica”.

Eliza e os “Invernos” da Inteligência Artificial

Além do Perceptron, outro sistema atraiu a atenção da mídia: o chatbot Eliza. Lançado em 1966, Eliza operava em uma máquina de grande porte. Segundo Karen Hao, tratava-se de uma IA simbólica baseada em regras simples, desenvolvida para simular atenção e responsividade, fazendo perguntas para extrair mais informações do usuário. O nome foi inspirado em Eliza Doolittle, personagem do filme “My Fair Lady”, que conseguia simular a fala e os modos da elite. O experimento validou a crença na “ilusão de inteligência”, com alguns psiquiatras chegando a prever a possibilidade de psicoterapia automatizada – um objetivo ainda hoje explorado pelas IAs contemporâneas.

Entretanto, o progresso na área não seguiu a velocidade esperada. Victor Sobreira, em seu artigo, detalha as severas críticas entre as décadas de 1960 e 1970, que resultaram em décadas de corte de financiamento para pesquisas em IA. Dentre elas, destacam-se a crítica de Hubert Dreyfus (1965), que comparava a IA à “alquimia”, e o trabalho do matemático James Lighthill (1973), que apontou as “explosões combinatórias” – a limitação de sistemas baseados em regras a contextos controlados e com poucas variáveis, insuficientes para o mundo real. Esses períodos de escassez de recursos ficaram conhecidos como os “invernos da inteligência artificial”, afetando o interesse social e político pela área, como relata Anderson Rocha.

Vitórias em Jogos: Impulsionando a Atenção para a IA

Os momentos de maior repercussão para a IA no imaginário popular ocorreram com as vitórias de máquinas contra humanos em jogos. Anderson Rocha, da Unicamp, enfatiza a importância dos jogos como “simulação de uma situação, muitas vezes conhecida, com regras e ambiente relativamente controlado, que permite avaliar bem seus algoritmos e técnicas”. Em 1968, um evento na casa de Donald Michie, fundador do Departamento de IA da Universidade de Edimburgo, marcou o início dessa relação. O campeão escocês de xadrez David Levy aceitou um desafio de John McCarthy, inventor do termo IA, vencendo-o. Contudo, McCarthy prometeu que em dez anos, um computador venceria Levy, que apostou 500 dólares que isso não ocorreria antes de 1979. Ele venceu essa aposta, perdendo para uma máquina (o programa Deep Thought) somente em 1989.

O episódio mais emblemático, no entanto, foi a vitória do computador Deep Blue da IBM sobre o campeão mundial russo Garry Kasparov em 1997. Segundo um artigo do próprio site da IBM, essa conquista “demonstrou que os computadores podem superar os seres humanos em jogos altamente estratégicos, há muito considerados um marco da inteligência humana”. Esse marco foi seguido pela vitória do AlphaGo em 2016 contra o campeão mundial do jogo de Go, tido como muito mais complexo que o xadrez devido à sua vastidão de possibilidades. No ano seguinte, uma equipe do Google publicaria um artigo fundamental que apresentaria as bases da IA generativa.

Transformer: O Alicerce da IA Generativa

Em 2017, a equipe do Google apresentou o Transformer, uma inovação em redes neurais que revolucionou a capacidade de as máquinas captarem o contexto das frases. Ao contrário de modelos anteriores, que processavam texto palavra por palavra, o Transformer analisava a frase como um todo, identificando quais trechos eram mais relevantes. Essa abordagem é como sublinhar as palavras-chave que conferem sentido à mensagem, algo exposto no artigo “Attention is All You Need”. Por exemplo, na frase “o gato sentou no tapete porque estava cansado”, o modelo relaciona “estava cansado” diretamente ao “gato”, ignorando a necessidade de seguir a ordem linear das palavras. Esse mecanismo, a autoatenção (`self-attention`), permite ao computador conectar cada palavra a todas as outras em uma frase ou segmento, e não apenas às adjacentes. Tal capacidade é o que torna possível para modelos responderem perguntas complexas e manterem conversas coerentes, ao atribuir mais relevância às partes mais importantes do que já foi comunicado. Inicialmente, o Transformer foi testado em tarefas de tradução.

No entanto, Ilya Sutskever, cofundador e cientista-chefe da então nascente OpenAI, enxergou um potencial que ia muito além da tradução ou das buscas online: o avanço do “deep learning” – técnica que utiliza redes neurais com muitas camadas para aprender padrões complexos a partir de grandes volumes de dados.

OpenAI e a Era GPT

No cenário descrito no livro “Empire of AI”, Sutskever percebeu o imenso potencial do artigo do Google sobre Transformers. A OpenAI, fundada em 2015 por nomes como Elon Musk e Sam Altman, tinha o objetivo de desenvolver IA de forma transparente e em benefício da humanidade. Pesquisadores da organização expandiram seu foco: em 2018, um artigo da OpenAI demonstrou que treinar um modelo de linguagem para prever a próxima palavra em milhões de frases lhe permitia adquirir um conhecimento que poderia ser reutilizado em diversas outras tarefas, como responder perguntas.

Para isso, a rede foi treinada com mais de sete mil livros inéditos de variados gêneros, oriundos de um dataset denominado BooksCorpus. Essa estratégia mostrou que, ao tentar gerar frases convincentes, o sistema absorvia profundas nuances da linguagem. Sutskever sintetizava essa visão na premissa de que “inteligência é compressão”: forçar a máquina a criar texto a fazia condensar o conhecimento sobre o mundo. O lançamento do GPT-1 (Generative Pre-Trained Transformer) em 2018 validou essa ideia, onde “pre-trained” indicava o treinamento em um vasto conjunto de textos antes de ajustes específicos. A partir do GPT-1, a evolução foi impulsionada pela escala, com o aumento progressivo do número de parâmetros, o que incrementou a capacidade do modelo de capturar nuances linguísticas com volumes maiores de texto, culminando em 2022 com o GPT-3.5, que serviu de base para o popular ChatGPT. Em 2018, Elon Musk deixou a OpenAI devido a divergências internas, e a organização transformou-se em uma empresa de propósito misto para captar os recursos necessários à pesquisa.

Limites e Desafios da IA Generativa Atual

A chegada dos modelos mais recentes da OpenAI, como o GPT-5, esperava-se um salto tecnológico substancial, à altura das transições anteriores. No entanto, o Financial Times questionou em um artigo se a “IA está atingindo uma parede”. Uma das principais críticas é que os ganhos de desempenho entre as versões se dão por uma mera ampliação dos dados e do poder computacional, uma fórmula que, segundo especialistas, possui limites. Sam Altman, da OpenAI, enfrentou críticas recentes pelo lançamento de um aplicativo de geração de vídeos via inteligência artificial, que alguns consideraram de “baixa qualidade” (“AI slop”) em comparação aos ambiciosos projetos da empresa. Em sua conta na rede X (antigo Twitter), Altman reconheceu a mensagem, mas reiterou a necessidade de capital para desenvolver IA capaz de “fazer ciência”, além de exibir “tecnologias/produtos interessantes ao longo do caminho” para angariar fundos.

Professor Anderson Rocha, da Unicamp, observa que modelos como o GPT-5, o novo Gemini e o Claude são fantásticos, mas “não conseguem lidar com aspectos básicos do raciocínio humano, como o senso comum, a noção de causa e consequência ou a capacidade de imaginar cenários contrafactuais”. Para ele, isso “não é algo que será trazido a partir de dados”, indicando um possível “limite”. Outro desafio premente é a necessidade de reduzir a dependência de grandes volumes de informação e recursos computacionais. Rocha defende que é preciso alcançar a performance atual “usando menos dados e menos energia, ou formas mais inteligentes de aprendizado”. Adicionalmente, há as implicações sociais e políticas, com a necessidade de sistemas que tomem decisões “mais explicáveis, auditáveis e menos enviesadas, para não reproduzir discriminações”. Quanto à inteligência humana, o professor é cético, apontando a natureza multifacetada da definição, que inclui aspectos emocionais, sociais, psicológicos e políticos. Para uma análise mais aprofundada dos sistemas da IBM, você pode consultar o material oficial da empresa que detalha a vitória do Deep Blue contra Garry Kasparov em 1997 em seu site oficial.

Finalmente, o pesquisador Victor Sobreira argumenta que a história da IA “ainda está por ser construída de forma rigorosa”, notando que a literatura existente é frequentemente autorreferencial e produzida por indivíduos próximos aos próprios pesquisadores, muitas vezes com financiamento dos objetos de pesquisa. Ele defende que muitas das narrativas existentes negligenciam o contexto político e social, exemplificando com a estreita ligação da área com as forças militares norte-americanas durante a Guerra Fria, um aspecto subexplorado na historiografia corrente. O exército dos EUA, ao lado de empresas privadas, demonstrou interesse direto no assunto e investiu significativamente, uma relação que carece de um aprofundamento rigoroso.

Imagem: bbc.com

Confira também: crédito imobiliário

A complexa jornada da inteligência artificial, desde as primeiras questões sobre o pensamento das máquinas até os desafios éticos e técnicos da atualidade, é um campo em constante desenvolvimento. Para aprofundar suas análises sobre as ramificações tecnológicas e sociais do século XXI, continue acompanhando as notícias e reflexões na editoria de Análises em nosso portal.

Crédito: Frederic Lewis via Getty Images

Recomendo

🔗 Links Úteis

Recursos externos recomendados