📚 Continue Lendo

Mais artigos do nosso blog

A corrida por infraestruturas robustas no campo da inteligência artificial atinge proporções massivas, com laboratórios dedicados à construção de data centers do tamanho de Manhattan. Cada um desses empreendimentos exige bilhões de dólares em investimento e consome energia comparável à de uma cidade de pequeno porte. Este ímpeto é motivado por uma convicção arraigada na ideia de escalabilidade, a crença de que um aumento exponencial no poder computacional, aplicado aos métodos existentes de treinamento de IA, culminará em sistemas superinteligentes capazes de executar uma vasta gama de tarefas. No entanto, Sara Hooker, figura proeminente na pesquisa de IA e ex-vice-presidente de Pesquisa de IA na Cohere, diverge dessa visão, apresentando uma perspectiva inovadora que prioriza a eficiência e o aprendizado contínuo.

Contrariando o consenso dominante, um número crescente de pesquisadores na área de IA sugere que a escalabilidade de Modelos de Linguagem Grandes (LLMs) pode estar atingindo seus limites práticos. Argumenta-se que avanços distintos podem ser necessários para aprimorar significativamente o desempenho da inteligência artificial. Essa premissa fundamenta a nova iniciativa de Sara Hooker: a startup Adaption Labs, co-fundada com Sudip Roy, outro veterano da Cohere e do Google.

Sara Hooker, Ex-Cohere, Aposta em Nova Abordagem de Otimização da IA

A Adaption Labs baseia-se na ideia de que a expansão de LLMs tem se tornado uma maneira cada vez mais ineficiente de extrair maior desempenho dos modelos de IA. Sara Hooker, que se desligou da Cohere em agosto do ano corrente, revelou discretamente sua nova empreitada este mês, visando expandir o recrutamento de talentos. Segundo Hooker, a iniciativa tem como foco principal a construção de “máquinas pensantes” que adaptem e aprendam continuamente, buscando superar as limitações atuais.

Em declarações a TechCrunch, Sara Hooker detalhou que a Adaption Labs está desenvolvendo sistemas de IA aptos a aprender e se adaptar ininterruptamente a partir de suas experiências no mundo real, de maneira altamente eficiente. Ela optou por não fornecer informações específicas sobre os métodos que embasam essa abordagem, nem se a empresa utiliza LLMs ou uma arquitetura distinta. “Estamos em um ponto de virada onde fica evidente que a fórmula de meramente escalar esses modelos – abordagens sedutoras, mas notavelmente entediantes – não resultou em inteligência capaz de navegar ou interagir com o mundo”, afirmou Hooker, reforçando sua convicção na necessidade de novas direções para a otimização da IA.

Os Desafios do Aprendizado Adaptativo e a Otimização da IA

A adaptabilidade é essencial para o processo de aprendizado, conforme explica Hooker. Ela exemplifica: tropeçar em um objeto uma vez ensina a ser mais cauteloso na próxima interação. Pesquisadores de IA têm buscado incorporar esse conceito através do Aprendizado por Reforço (RL), que permite que modelos de IA aprendam com erros em ambientes controlados. Contudo, as metodologias de RL existentes hoje não capacitam os modelos de IA já em uso por clientes – sistemas em produção – a aprender em tempo real com suas falhas. Em vez disso, repetem os mesmos erros de forma persistente, o que evidencia uma lacuna crucial na inteligência artificial atual. Atualmente, alguns laboratórios de IA oferecem consultoria para que empresas possam ajustar seus modelos às necessidades personalizadas, mas a um custo considerável. A OpenAI, por exemplo, exige um gasto superior a US$ 10 milhões para oferecer seus serviços de ajuste fino a clientes corporativos.

Hooker ressalta que “há um pequeno grupo de laboratórios de fronteira que ditam o conjunto de modelos de IA, os quais são servidos da mesma forma a todos e são caríssimos para adaptar”. Ela argumenta que essa realidade não precisa ser permanente, e que sistemas de IA podem aprender eficientemente de um ambiente. A comprovação dessa capacidade alteraria drasticamente a dinâmica de quem detém o controle e a modelagem da IA, definindo a quem, de fato, esses modelos servirão no futuro, fortalecendo a visão de Adaption Labs como pioneira na otimização da IA.

Uma Mudança de Paradigma na Indústria da Inteligência Artificial

A Adaption Labs representa o mais recente indicativo de que a confiança da indústria na escalabilidade de LLMs está começando a declinar. Relatórios recentes de pesquisadores do MIT (Massachusetts Institute of Technology) revelaram que os maiores modelos de IA do mundo podem estar se aproximando de um ponto de retornos decrescentes. Observa-se também uma mudança na percepção geral em São Francisco, centro nevrálgico da tecnologia. O popular podcaster Dwarkesh Patel, frequentemente associado ao universo da IA, conduziu discussões com proeminentes pesquisadores que manifestaram ceticismo incomum sobre as estratégias atuais. Richard Sutton, laureado com o prêmio Turing e considerado um dos “pais” do Aprendizado por Reforço (RL), declarou em setembro a Patel que os LLMs não podem ser verdadeiramente escalados por não aprenderem com experiências do mundo real. Este mês, Andrej Karpathy, um dos primeiros funcionários da OpenAI, compartilhou suas ressalvas sobre o potencial de longo prazo do RL para aprimorar os modelos de IA, evidenciando que a busca por otimização da IA segue caminhos complexos e diversificados.

Essa série de preocupações não é inédita no cenário da inteligência artificial. No final de 2024, alguns pesquisadores já manifestavam receios de que a escalabilidade de modelos de IA através do pré-treinamento — processo no qual modelos de IA assimilam padrões a partir de vastos conjuntos de dados — estivesse alcançando rendimentos decrescentes. Até aquele momento, o pré-treinamento era visto como o “ingrediente secreto” que permitia à OpenAI e ao Google aprimorar seus modelos de maneira consistente.

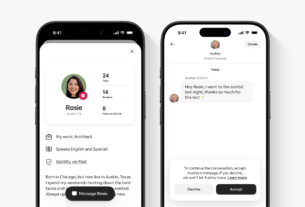

Imagem: techcrunch.com

Novas Fronteiras e os Custos Elevados da Pesquisa

As preocupações acerca da escalabilidade do pré-treinamento agora se refletem nos dados disponíveis. Contudo, a indústria de IA tem encontrado outras vias para melhorar seus modelos. Em 2025, avanços significativos ocorreram em torno dos modelos de raciocínio de IA, que despendem tempo e recursos computacionais adicionais para processar problemas antes de oferecer respostas, impulsionando ainda mais as capacidades dos modelos existentes. A comunidade de IA parece convencida de que a expansão de RL e dos modelos de raciocínio de IA constitui a nova fronteira de pesquisa, um novo capítulo na otimização da IA. Pesquisadores da OpenAI já haviam informado a TechCrunch que desenvolveram seu primeiro modelo de raciocínio de IA, denominado o1, antevendo seu grande potencial de escalabilidade. Além disso, pesquisadores da Meta e da Periodic Labs lançaram recentemente um estudo que explora como o RL poderia expandir o desempenho ainda mais — uma pesquisa que, segundo relatos, custou mais de US$ 4 milhões, sublinhando a exorbitância das abordagens atuais em termos de investimento financeiro.

A Adaption Labs, por outro lado, busca identificar a próxima inovação disruptiva e comprovar que o aprendizado baseado na experiência pode ser consideravelmente mais acessível. A startup manteve negociações no outono passado para levantar uma rodada de financiamento seed entre US$ 20 milhões e US$ 40 milhões, conforme três investidores que analisaram seus materiais de apresentação. Embora a quantia final não tenha sido confirmada, os investidores indicaram que a rodada foi concluída. Hooker absteve-se de comentar os detalhes. Quando questionada sobre seus investidores, Hooker afirmou que a empresa está “montada para ser muito ambiciosa”.

O Potencial Transformador da Adaption Labs na Otimização da IA

Anteriormente, Sara Hooker liderou a Cohere Labs, onde se dedicou ao treinamento de modelos de IA compactos para aplicação em cenários empresariais. Atualmente, sistemas de IA mais enxutos frequentemente superam suas contrapartes de maior porte em parâmetros de codificação, matemática e raciocínio – uma tendência que Hooker aspira continuar a impulsionar com Adaption Labs e sua foco na otimização da IA. Sua atuação anterior também se destacou pela ampliação do acesso à pesquisa de inteligência artificial em escala global, recrutando talentos de regiões sub-representadas, como a África. Embora a Adaption Labs esteja se preparando para inaugurar um escritório em São Francisco em breve, Hooker planeja expandir sua equipe de forma global.

Caso as suposições de Sara Hooker e da Adaption Labs sobre as limitações inerentes à escalabilidade se provem corretas, as implicações para o campo da inteligência artificial poderão ser gigantescas. Bilhões de dólares já foram aplicados na expansão de LLMs, com a expectativa de que modelos maiores levariam à inteligência geral. No entanto, é plenamente possível que o verdadeiro aprendizado adaptativo não apenas demonstre ser mais potente, mas também significativamente mais eficiente, redefinindo o futuro da otimização da IA e o desenvolvimento de soluções mais robustas e acessíveis. Acompanhe a seguir para entender as tendências de investimento nesse cenário de constante transformação.

Confira também: crédito imobiliário

A tese da Adaption Labs de que o aprendizado adaptativo pode ser a chave para o avanço da inteligência artificial representa uma importante contra-corrente na indústria dominada pela busca incessante por mais poder computacional. Este novo enfoque não apenas promete otimizar a IA de forma mais sustentável, mas também democratizar seu desenvolvimento e controle. Continue explorando as novidades em tecnologia e as principais tendências de mercado em nossa editoria para acompanhar de perto as próximas evoluções da inteligência artificial. Para mais análises sobre os rumos do desenvolvimento tecnológico e suas implicações socioeconômicas, visite nossa seção de análises e mantenha-se informado sobre como esses avanços podem moldar nosso futuro.

Crédito da imagem: Maxwell Zeff

Recomendo

🔗 Links Úteis

Recursos externos recomendados